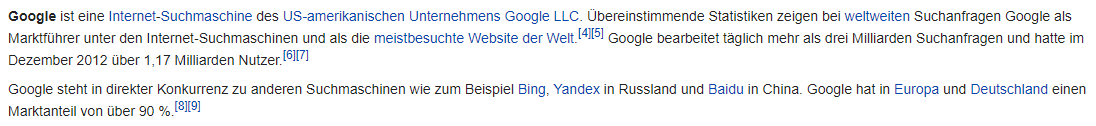

OnPage-Optimierung umfasst alle Maßnahmen, welche direkt auf der eigenen Seite vorgenommen werden können.

In den nachfolgenden Kapiteln werden eine Reihe einzelner Maßnahmen gelistet und kurz erläutert, welche für eine erfolgreiche Suchmaschinenoptimierung erforderlich sind.

Unter Berücksichtigung bestimmter Faktoren, kann eine Optimierung zu einer höheren Relevanz unter entsprechenden Suchanfragen führen.

Bevor inhaltliche Aspekte einer Website überarbeitet werden, sollten vorerst stets die technischen Kriterien überprüft werden.

Meta-Informationen

Wenn man Suchmaschinenoptimierung betreibt, muss man sich im Klaren sein, dass jede Information für die Crawler der Suchmaschinen wertvoll sein kann.

Es gilt also eine Aufbereitung der Informationen durchzuführen, welche nicht nur für den Menschen sichtbar sind, sondern ebenso für die Suchmaschinen. Dabei ist es wichtig, diese so optimal wie möglich zu gestalten.

Mit Hilfe von sogenannten Meta-Elementen lassen sich Informationen für die Crawler bereitstellen.

Unter Meta-Informationen (auch Meta-Tags genannt) versteht man die im Header-Bereich eines HTML-Codes zur Verfügung gestellten komprimierten Informationen eines Dokuments.

In diesem Kapitel werden elementare Meta-Elemente angesprochen. Es gibt noch eine Vielzahl weiterer Tags, welche eingesetzt werden können.

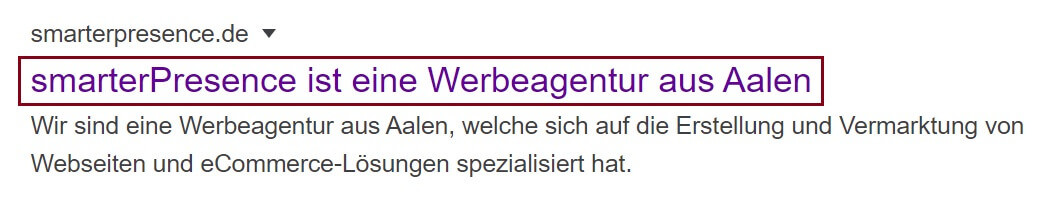

Title

Das Title Element wird häufig als Meta-Title oder Title-Tag bezeichnet und ist eines der wichtigsten Elemente, wenn es um SEO geht.

Diesem Element rechnen sämtliche Suchmaschinen eine hohe Gewichtung zu. Das liegt daran, dass hier, wie sonst nirgendwo im Dokument, der Inhalt so präzise wie möglich formuliert werden muss.

Die Angaben im Meta-Title werden in der Titelzeile eines jeden Browsers dargestellt, da hier nur eine Zeile mit einer variablen, aber doch stark beschränkten Breite zur Verfügung steht, werden Webmaster stets angehalten sich kurz zu fassen. Dies garantiert meist die Integrität der jeweiligen Titel.

Das Title-Element dient ebenso der Websitebeschreibung, welche in den Suchergebnisseiten dargestellt wird.

Es fungiert als Überschrift für die Anzeigen der Suchmaschinenergebnisse und ist somit das erste Element, welches einem Nutzer ins Auge fällt, wenn dieser Ihre Seite in den Suchergebnissen findet.

Jeder Title sollte eine gewisse Prägnanz vorweisen können und vor allem das Thema der Seite widerspiegeln. Stellen Sie sicher, dass das Title-Element jeder Seite einzigartig ist.

Ebenso sollte es nach Möglichkeit das wichtigste Keyword der jeweiligen Zielseite enthalten und dieses sollte so weit vorne wie möglich stehen.

Expertentipp

Die Länge des Title-Elements sollte zwischen 40 bis 60 Zeichen liegen.

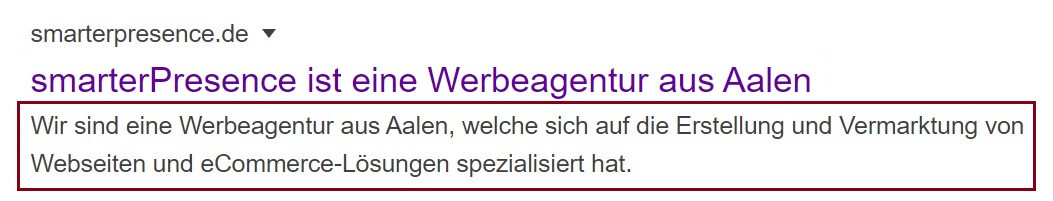

Description

Stellen Sie sicher, dass jede Seite eine einzigartige Meta-Description besitzt. Mit Hilfe des Description-Elements können Suchmaschinen themenrelevante Inhalte auf den Ergebnisseiten darstellen.

Die Description sollte so prägnant und präzise wie möglich sein. Das bedeutet, sie muss das Thema der Website treffend wiedergeben und dazu auch noch im Kontext Sinn ergeben.

Expertentipp

Die empfohlene Länge liegt hier bei 160-180 Zeichen. Meist werden Texte gewählt, welche den Suchenden neugierig werden lassen.

Mit Hilfe einer guten und individuellen Meta-Description kann man die Klickrate über die Suchergebnisse beeinflussen.

Robots

Mit Hilfe des Robots-Elements können Webmaster die Indexierung bestimmter Seiten durch Suchmaschinen verbieten.

Expertentipp

Überprüfen Sie die Robots-Elemente auf all Ihren Seiten. Wenn Sie eine Abweichung finden, haben Sie wahrscheinlich bereits erste Schwierigkeiten entdeckt. Bspw. kann ein unbeabsichtigtes no-index sich negativ auf Ihre Suchmaschinenranking-Pläne auswirken.

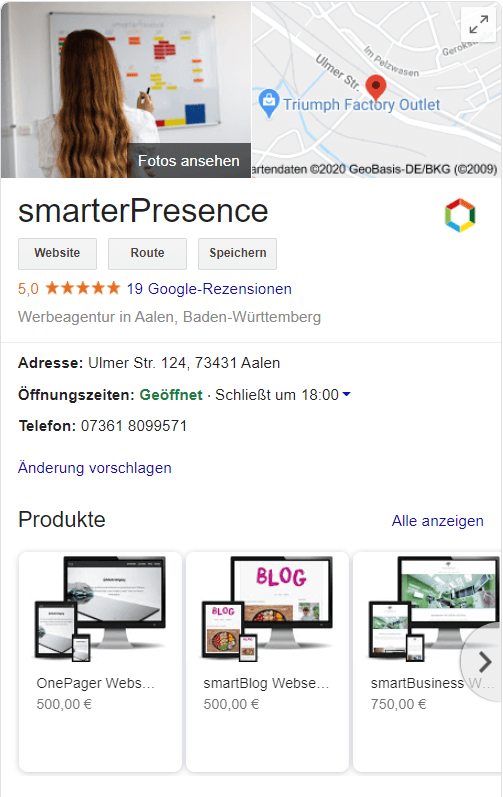

Geo

Geo-Tags vermitteln Informationen über den räumlichen Standort. Etwa 25% aller eingehenden Suchanfragen beziehen sich auf einen Ort.

Das zeigt wie wertvoll derartige Angaben für eine Plattform sein können.

Wenn Sie z.B. für “Aalen Pizza” ranken wollen, weil Sie einen Pizzaladen in Aalen besitzen, so sollten Sie sicherstellen, dass Ihre Adresse auf jeder Seite Ihrer Website vertreten ist.

Ebenfalls sollten Sie die Suchergebnisse in Google Maps kontrollieren, um zu sehen, ob Sie dort mit einem Google MyBusiness Eintrag vertreten sind.

Struktur und Darstellung

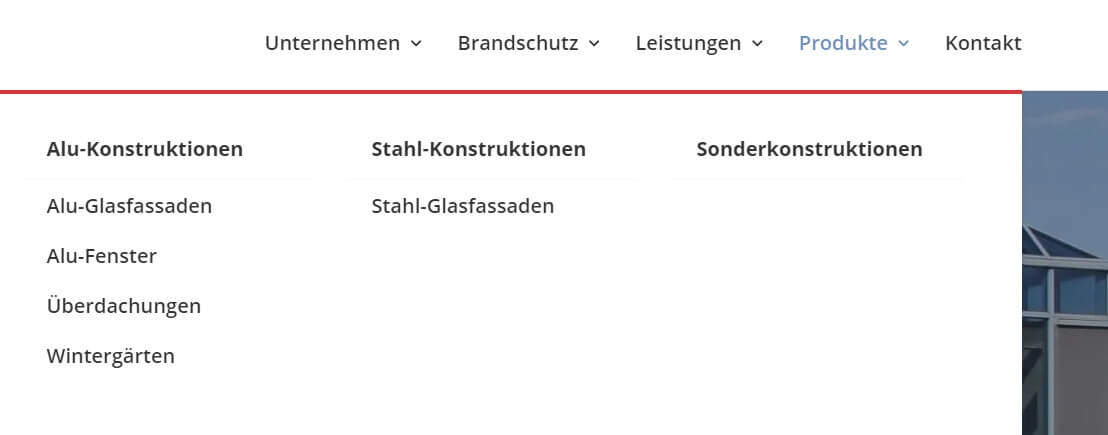

Alle einzelnen Seiten der Seitenstruktur einer Website müssen so organisiert werden, dass diese zueinander in einer logischen und hierarchischen Beziehung stehen. Die Anordnung sollte für den Benutzer stets transparent und verständlich erscheinen.

Der Crawler von Google folgt strikt den Links, welche Sie ihm zur Verfügung stellen. Wenn es beabsichtigt ist, dass alle Seiten im Index der Suchmaschine repräsentiert werden, so muss jede Seite über einen Link der Website erreicht werden. Es gilt die Navigationssteuerleisten sowie Abschnittsüberschriften zu überprüfen.

Um das Thema eines bestimmten Abschnitts zu bestimmen sollten stets beschreibende Überschriften vorhanden sein. Überschriften werden mit dem H1-H6 Tag ausgezeichnet. Bei der Nummerierung handelt es sich um eine Form der Untergliederung.

Der H1-Tag steht für die höchste Ebene und sollte dementsprechend mit wichtigen Schlüsselbegriffen belegt werden.

Der H2-Tag kann als Unterüberschrift verwendet werden, ihm wird demnach eine nicht ganz so hohe Priorität von den Suchmaschinen beigemessen.

Suchmaschinen schließen Überschriften für ihre Berechnungen der Gewichtungen einzelner Seiten mit ein.

Abgesehen von den Vorteilen hinsichtlich SEO, zeugt es von einem ordentlichen Programmierstil und sauberem Design, wenn Überschriften so eingesetzt werden, dass sie für den Anwender zielführend sind.

Hinter einer großen, fetten Überschrift wird generell wichtiger Inhalt vermutet, demnach werden Ihre Besucher enttäuscht sein wenn sie diesen nicht vorfinden.

Eine klar gegliederte Website, welche eine sinnvolle Struktur besitzt, schafft eine wesentliche Erleichterung für den Benutzer, sowohl bei der Handhabung, als auch bei der Orientierung.

Die Suchmaschinen hingegen lassen die Gesamtstruktur in ihre Berechnungen mit einfließen, in dem sie bspw. die Verzeichnistiefe einer Seite bestimmen.

Es wird davon ausgegangen das relevante Dokumente sich weiter oben in einer Struktur befinden und weniger relevante Dokumente tiefer liegen.

Hierzu gibt es Hinweise für Vorgehensweisen, welche am Besten bereits vor der Umsetzung bedacht werden sollten.

Ein Schlüsselfaktor zur Bewertung der Relevanz ist die Anzahl an Klicks, welche benötigt wird, um von der Startseite auf die gewünschte Seite zu gelangen.

Eine Unterseite, welche sich nur einen Klick von der Hauptseite entfernt befindet, muss zweifelsohne eine wichtige Seite sein. Eine Seite, welche wiederum fünf oder mehr Klicks von der Hauptseite entfernt ist, ist bei weitem nicht so einflussreich. In der Tat kann es vorkommen, dass die Suchmaschine eine derartige Seite niemals findet. Dies ist aber auch immer von der Relevanz der Links auf der jeweiligen Seite abhängig.

Aus Erfahrungsberichten lässt sich schließen, dass generell nie mit mehr als drei Ebenen gearbeitet werden sollte.

Expertentipp

Seitenstruktur so flach wie möglich halten.

Minimieren Sie die Anzahl an benötigten Klicks von der Startseite zu allen wichtigen Inhalten. Das soll nicht bedeuten, dass alle Seiten direkt von Ihrer Startseite aus erreichbar sind, zu viele Links auf einer Seite sind ebenfalls nicht gut für Suchmaschinen.

Letztlich lässt sich sagen, dass Sie eine Seitenstruktur planen müssen, welche so flach wie möglich ist ohne dabei eine Beeinträchtigung der User-Experience darzustellen.

Wenn eine Seite unterschiedliche Themen umfasst, kann Google mehr damit anfangen, wenn es für jeden dieser Themenbereiche auch eine eigene Seite gibt. Hierbei sollte darauf geachtet werden das Seitentitel auch stets zum dargestellten Inhalt passen. Durch diese Aufteilung wird es den Suchmaschinen erleichtert alle Informationen zu erfassen und zu indizieren.

Soll bspw. ein Internetauftritt für einen Künstler erstellt werden, welcher sich sowohl mit der Malerei als auch mit dem Theater beschäftigt, so ist es sinnvoll diese beiden Tätigkeiten nicht unter einer Seite zusammen zu fassen, sondern für jeden Bereich eine separate Seite anzulegen, welche sich intensiv und gezielt mit dem jeweiligen Thema beschäftigt.

Die Startseite bietet sich zur Positionierung von aktuellen Mitteilungen an. Besuchern welche sich ziellos auf Ihre Seite begeben haben, kann hier direkt eine Orientierungshilfe angeboten werden.

Eine ausführliche Beschreibung der Hauptnavigationspunkte und eine zusätzliche Nennung weiterführender Verweise kann für den Besucher eine starke Hilfestellung sein. Zudem bietet es die Möglichkeit, auf eine natürliche Weise Stichwörter direkt auf der Startseite zu positionieren.

Expertentipp

Da die Startseite meistens für den ersten Eindruck verantwortlich ist, gilt es hier besonders auf Klarheit und Transparenz zu achten.

Goldene Regel

Eine Website wird in erster Linie für Menschen erstellt und nicht für Maschinen. Generell stimmen die Interessen dieser beiden Parteien sowieso überein. Eine gut organisierte Seite, welche leicht zu bedienen ist und deren Bezeichnungen eindeutig gewählt wurden, ist auch für einen Crawler leichter zu erfassen.

Die Prioritäten sollten stets an den Interessen der Besucher ausgerichtet werden.

Letztlich sollte die logische Struktur Ihrer Seite mit der Denkweise der Anwender übereinstimmen, hinsichtlich der Art wie sie über Produkte und Dienstleistungen denken.

Es sollte stets mit Begrifflichkeiten gearbeitet werden, welche auch von Menschen im Alltag und bei der Suche eingesetzt werden.

Strukturelle Entscheidungen

Eine der grundlegendsten Entscheidungen, welche über eine Website oder einen Online-Shop getroffen werden müssen, ist die interne Verlinkung sowie die Navigationsstruktur.

- Welche Seiten werden von der Startseite direkt verlinkt?

- Welche Seiten werden als Top-Level Kategorien verwendet, die dann zu anderen verwandten Seiten führen?

- Sind die Seiten, welche eine Relevanz zueinander besitzen, miteinander verlinkt?

Es gibt eine Vielzahl an Aspekten, welche die Linkstruktur einer Seite bestimmen. Es ist eine Hauptaufgabe der Usability einer Seite den Besucher dazu zu bringen die Links zu benutzen und Ihre Seite zu erforschen.

Für Suchmaschinen ist die Linkstruktur ebenfalls sehr interessant, sie hilft den Crawlern dabei zu bestimmen, welche Seiten ihrer Meinung nach am wichtigsten sind und wie diese zueinander in Beziehung stehen (Unterseiten einer Kategorie gehören zur Hauptkategorie usw.).

Eine durchdachte und organisierte Navigation stellt für ein schnelles Auffinden von Inhalten hierbei allerdings die wichtigste Vorbedingung dar.

Der Besucher sollte also zu jedem Zeitpunkt der Navigation genau wissen wo er sich momentan befindet. Es gibt einfache, elegante und etablierte Wege, um mit Hilfe von Konventionen eine Orientierung zu gewährleisten. Die sogenannte Breadcrumb-Navigation ist eine davon.

Es wird empfohlen ausschließlich Textlinks innerhalb der Navigation zu verwenden.

Sitemap

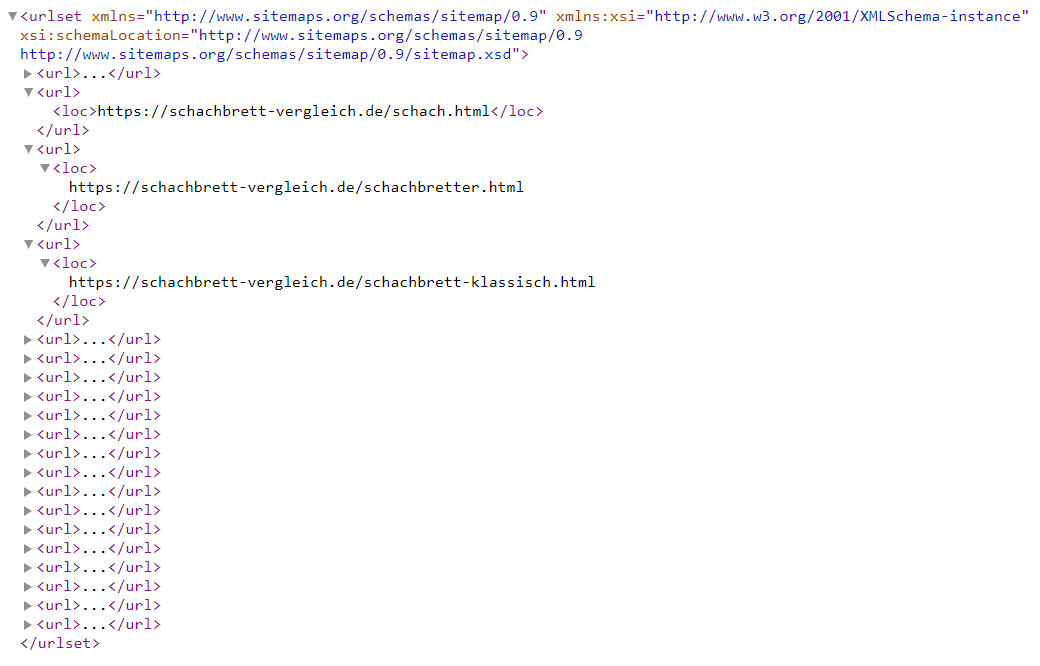

Auf einer Sitemap wird die komplette Struktur einer Website abgebildet, dabei wird innerhalb der Sitemap auf jede einzelne Seite verwiesen.

Für eine schnelle Indexierung der einzelnen Seite wird eine Sitemap als XML-Datei generiert und in der Google Search Console eingereicht.

Fehlerseiten und Umleitungen

Fehlerseiten und Umleitungen helfen bspw. dabei fehlerhafte Eingaben abzufangen, den Anwender zu informieren und Lösungen anzubieten.

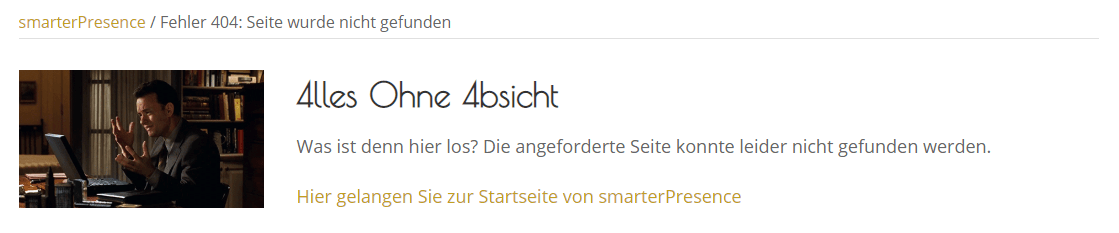

Fehlerseite (404)

Ein wichtiger Faktor ist die Konfiguration einer Fehlerseite (404), welche beim Aufruf einer nicht vorhandenen Ressource angezeigt werden kann.

Hier bietet sich ebenfalls die Verwendung der Sitemap an. Von dort aus kann der Besucher sich dann bequem neu orientieren und verlässt die Seite nicht sofort.

Ebenso kann eine eigens gestaltete Fehlerseite für Abhilfe sorgen. Der Besucher wird somit nicht durch eine Standard-Fehlerseite abgeschreckt, sondern über seine fehlerhafte Eingabe informiert.

Permanente Umleitung (301)

Verwenden Sie einen Server-Header-Checker um sicherzustellen, dass alle verwendeten Umleitungen auf der Seite einen 301 HTTP Status Code wiedergeben.

Kontrollieren Sie alle Umleitungen auf diese Art um sicher zu gehen, dass alles korrekt abläuft. Dies beinhaltet ebenso die Überprüfung der kanonischen Umleitung auf eine ordnungsgemäße Implementierung.

Temporäre Umleitung (302)

Dies ist ein häufig auftretendes Problem auf Web-Server Plattformen oder bei Content Management Systemen (CMS). Die 302 Umleitung blockiert Suchmaschinen, diese können Ihre Absicht Inhalte zu bewegen nicht erkennen und sind dadurch sehr problematisch für SEO.

Sie sollten in jedem Fall sicher gehen, dass die standardmäßige Weiterleitung (sofern diese vorhanden) Ihres Systems ein 301 ist. Oder Sie machen sich mit der Konfiguration vertraut, sodass Sie es selber einstellen können.

Interne Verlinkung

Links, welche nicht auf externe Quellen verweisen, sondern die eigenen Unterseiten referenzieren, werden interne Links genannt.

Google honoriert eine Website, wenn diese über eine durchdachte interne Verlinkung verfügt. Die Suchmaschine leitet daraus die Bedeutung einzelner Seiten ab.

So ist bspw. eine Seite, welche ordentlich verlinkt ist und sich nicht irgendwo versteckt auf der Website befindet, relevanter als eine, welche kaum über Verlinkungen verfügt und nur über bestimmte Unterseiten erreichbar ist.

Viele interne Links im Inhaltsbereich sind zudem ein Indiz für eine hohe Relevanz der Seite.

Wenn Unterseiten aus einem Text heraus verlinkt werden, macht es durchaus Sinn das Title-Attribut der jeweiligen Seiten zu verwenden. Das bedeutet, wenn Sie bspw. in einem Text über ein Schlüsselwort wie „Lederarmband“ auf die entsprechende Unterseite Ihrer Plattform verlinken möchten, so achten Sie darauf, dass der Besucher unter diesem Link das genannte Produkt findet und die URL der Unterseite auch bspw. www.beispieldomain.de/lederarmband lautet.

Ankertexte sind ein mächtiges Werkzeug der internen Verlinkung. Als Entwickler müssen Sie am besten direkt von Anfang in Ihrem Plan berücksichtigen, Keywordreiche Ankertexte in Ihrer internen Verlinkung zu verwenden.

Versuchen Sie Beschreibungstexte wie „More“ oder „Klicke hier“ zu vermeiden und stellen Sie sicher, dass Ihr Techniker und Ihre Redakteure dies verstehen. Sie sollten ebenfalls Zeit in eine Ankertext-Strategie für Ihre Seite investieren.

Quellcode und Content

Die Grundvoraussetzung für eine erfolgreiche Optimierung und eine gelungene Website überhaupt, ist der korrekte Umgang mit den zu Grunde liegenden Web-Technologien HTML und CSS.

Die richtige Formatierung des Quellcodes erleichtert es den Suchmaschinen themenrelevante Inhalte aufzufinden.

Die Gestaltung der themenrelevanten Inhaltstexte ist für eine erfolgreiche Optimierung ebenso unerlässlich.

Sauberer Quellcode

Browser besitzen einen toleranten Parser und können Seiten trotz Fehler im HTML-Quellcode, meist problemlos interpretieren und anzeigen.

Die Crawler der Suchmaschinen sind hingegen nicht so fehlertolerant. Es wird daher ausdrücklich empfohlen auf einen sauberen Code zu achten, welcher keine syntaktischen Fehler beinhaltet.

Da Crawler auf einzelne Elemente wie z.B. den Title-Tag zugreifen, um diesen eine gesonderte Gewichtung zu verleihen, ist es von enormer Wichtigkeit das der HTML-Code die Auszeichnungen erkennen lässt.

Schlechter Quellcode kann unerwünschte Auswirkungen zur Folge haben.

Hier kann mit Hilfe eines Tools wie dem SEO Browser die Seite so dargestellt werden, wie sie von Suchmaschinen gesehen wird.

Sollte man beispielhaft eine simple, schließende eckige Klammer vergessen haben, kann dies schon zu einer Nichtberücksichtigung ganzer Teile des Dokumentes führen.

Häufig werden Fehler bei der Verwendung der Anführungszeichen gemacht. Wenn diese nicht im Paar einen Wert umschließen, kann es sein, dass der Parser alles vom ersten Anführungszeichen bis hin zum nächsten, als den Wert eines Attributs interpretiert.

Das W3C (World Wide Web Consortium) bietet eine Art Gültigkeitscheck an, welcher es den Webmastern ermöglicht Ihren HTML-Code auf Syntaxfehler hin überprüfen zu lassen.

Hier kann entweder einfach die URL zum jeweiligen Dokument angegeben, oder unveröffentlichte HTML-Dateien zur Überprüfung hochgeladen werden.

Wertvoller Content

Eine suchmaschinenfreundliche Seite verfügt über Inhaltstexte, welche das Thema der Seite inhaltlich und deutlich vermitteln.

Generell sollte beim Schreiben von Texten immer darauf geachtet werden, dass man das jeweilige Thema in einer intensiven und sachlichen Art behandelt.

Wichtige Schlüsselbegriffe werden hier von selbst genannt und eine Auseinandersetzung mit der richtigen Keyword-Dichte ist nicht erforderlich.

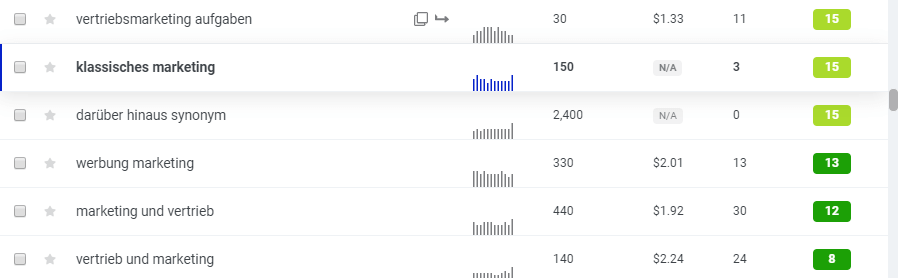

Im Idealfall sollten Sie sich aber noch bevor Sie Ihre Plattform aufsetzen über Schlüsselbegriffe, welche den Inhalt Ihrer Plattform wiedergeben Gedanken machen.

Versetzen Sie sich in die Lage des idealen Besuchers, welcher an den Inhalten und Angeboten Ihrer Seite interessiert ist. Wie würde dieser Besucher seine Suchanfrage formulieren? Welche Schlüsselbegriffe würde er einsetzen um schnellstmöglich zu seinem Ziel zu gelangen? Eben diese Begriffe sind der Schlüssel, nach dem Sie Ihre Inhalte schmücken sollten.

Die relevantesten unter diesen Begriffen sollten auf den Inhaltsseiten und allgemein in den Texten Ihrer Plattform erscheinen. Unter anderem sollten Sie in Überschriften, Seitentexten sowie Seitentiteln und Meta-Tags vorhanden sein.

Achten Sie hierbei aber darauf, dass der Besucher nicht von den Begrifflichkeiten erschlagen wird, oder die Textqualität darunter leidet. Sollte Ihre Seite unter den von ihnen optimierten Suchbegriffen eine schlechte Platzierung erfahren oder überhaupt nicht auftauchen, so kann dies mehrere Gründe haben.

Zum einen besitzt nicht jeder Suchbegriff denselben Wert, Begriffe wie „Filme“ oder „Musik“ stehen einer so großen Konkurrenz gegenüber, dass ein gutes Ranking unter derart allgemeinen Begrifflichkeiten fast unmöglich bzw. nur mit erheblichen Aufwand möglich ist.

Es empfiehlt sich hier konkret zu werden und Begriffe welche Ihre Plattform auszeichnen zu verwenden, bspw. Begriffe wie „Immobilienmakler Aalen“ oder „Makler für Eigentumswohnungen“.

Eine Keywordrecherche ist für eine erfolgsversprechende Optimierung essentiell.

Themenrelevanter Inhalt einer Website bietet außerdem die Möglichkeit sich von der Konkurrenz abzuheben und die Reichweite für potenzielle Zielgruppen zu erweitern.

Neben den Besuchern sind es vor allem Suchmaschinen, welche einmaligen Content einer Seite honorieren.

Die Informationen aus Texten, Grafiken und Videos haben direkten Einfluss auf die Relevanz einer Seite. Je höher die Relevanz, desto größer ist die Wahrscheinlichkeit mit einem guten Ranking in den Suchergebnissen abzuschneiden.

Alle Grafiken einer Website sollten mit Alt-Texten ausgezeichnet werden, damit Suchmaschinen verstehen können was auf einem Bild dargestellt wird. Diese Maßnahme verstärkt den gesamten Kontext Ihrer Seite. Dieser Kontext kann weiter verstärkt werden indem genauso mit den Dateinamen der Grafiken verfahren wird.

So wie es zu einem guten Stil gehört die Unterseiten einer Website mit sprechenden Bezeichnern zu versehen, so gilt dies auch für Bilddateien. Versuchen Sie im Bildnamen den dargestellten Gegenstand zu beschreiben.

Bei der Namensfindung können folgende Fragen behilflich sein:

- Was wird auf dem Bild dargestellt?

- Welche Begriffe verwenden potenzielle Kunden, wenn sie nach diesem Produkt suchen?

Das Bild sollte so genau wie möglich beschrieben werden, hierbei können Sie ruhig mehrere Begriffe verwenden.

Die Chance, in den Bild-Suchergebnissen angezeigt zu werden, wird durch die richtig geschaffene Zuordnung erhöht.

Ebenso erhöhen sich die Chancen, dass Bilder gemeinsam mit der Website in den Suchergebnisseiten dargestellt werden.

Beachten Sie bei der abschließenden Überprüfung der Inhaltstexte sowie des Quellcodes folgende Faktoren:

- Besitzen die wichtigsten Seiten Ihres Internetauftritts genügend Inhalt?

- Werden bei allen Seiten Header-Tags (Überschriften) verwendet?

Eine etwas subtilere Variante dieser Überprüfung ist es darauf zu achten, dass der Prozentanteil der Seiten, welche über wenig Inhalt verfügen nicht zu hoch im Vergleich zur Gesamtzahl der Seiten auf Ihrer Website ist.

Das Verhältnis von Inhalten, welche für den Besucher dargestellt werden und der dazu benötigte Quellcode werden von den Suchmaschinen bewertet. Wenn eine Seite nur wenig Inhalt anbietet, aber aus Unmengen Quellcode besteht, so wird sich das negativ auf die Suchmaschinenbewertung auswirken.

Strukturierte Daten

Auf komplexen Websites und Onlineshops werden technisch gesehen Unmengen an Informationen verarbeitet. In den Datenbanken werden die einzelnen Produkte mit möglichst vielen und relevanten Informationen versehen. Für die Suchmaschinen sind diese Informationen aber nicht ersichtlich, sie analysieren nur den zu Grunde liegenden HTML-Quelltext.

Das bedeutet, dass alle Angaben in der Datenbank, welche sich nicht direkt auf der Seite befinden für die Suchmaschinen unsichtbar sind.

Um dem entgegenzuwirken und derartige wertvolle Informationen für Suchmaschinen aufzubereiten, müssen diese in maschinenlesbarer Sprache im Quelltext hinterlegt werden.

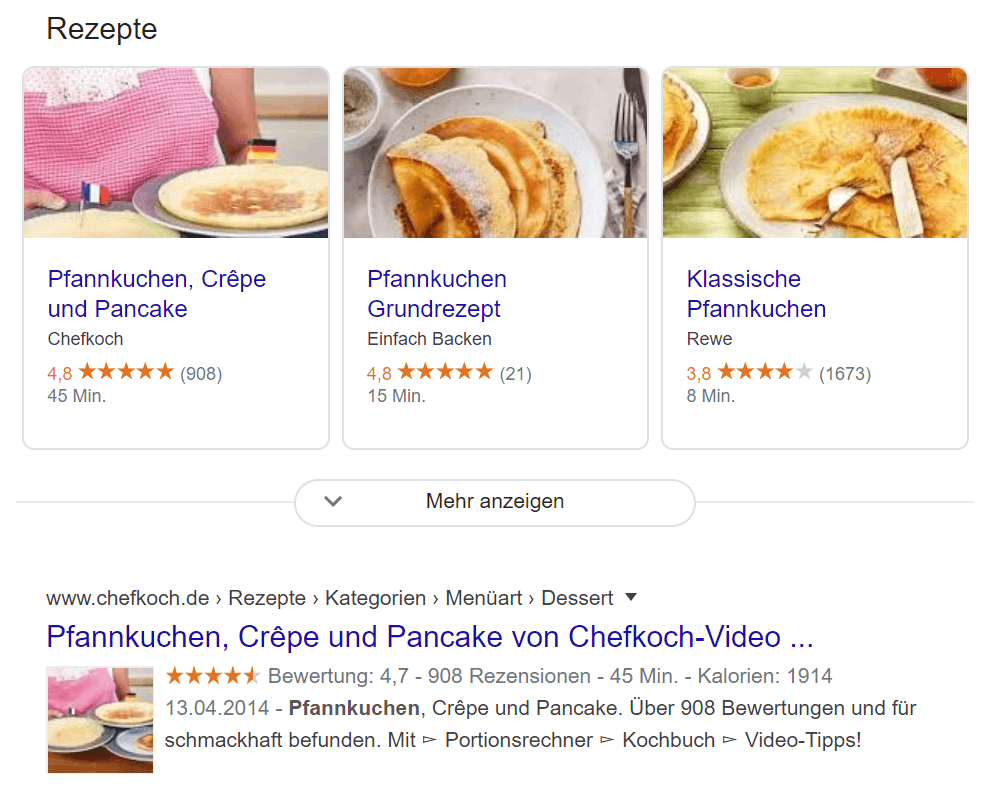

Mit Hilfe von strukturierten Daten, können die eigenen Seiten in den Suchergebnissen mit wertvollen Informationen angereichert werden.

Diese geben dem Suchenden nicht nur eine schnellere Auskunft, sondern fallen ihm durch die optische Hervorhebung auch ins Auge. Diese wertvollen Informationen können bspw. einen positiven Effekt auf die Kaufentscheidungen haben.

Mit Hilfe eines Markups kann den Suchmaschinen vermittelt werden, wo genau sich die Anhaltspunkte zur Erstellung von sogenannten Rich Snippets befinden.

Es gibt drei verschiedene Formen, um Daten auszuzeichnen:

- Mikrodaten

- Mikroformate

- RDFa

Mit deren Hilfe können nicht nur Produkte in Online-Shops ausgezeichnet werden, sondern auch Inhalte wie Beurteilungen, Ereignisse und Videocontent.

Durch eine Strukturierung der Daten können Suchmaschinen diese interpretieren und verstehen. Die Angabe, um welche Information es sich handelt, erleichtert den Suchmaschinen die Zuordnung und die korrekte Darstellung.

Wenn eine Person auf einer Website der Autor eines Buches ist und auf einer anderen der Geschäftsführer einer Agentur, kann hier mit Hilfe der Übermittlung von strukturierten Daten den Suchmaschinen die Möglichkeit gegeben werden, derartige Zusammenhänge zu verstehen und diese auch richtig darzustellen.

Durch eine Sterne-Bewertung kann der Suchende sich schnell ein Bild davon machen was andere Besucher von dieser Seite halten und ob der angebotene Inhalt (in diesem Fall ein Rezept) hilfreich war.

Zusätzlich wird ein Bild des Gerichts dargestellt und die Anzahl der Rezensionen sowie die Zubereitungsdauer. Das alles sind wertvolle Informationen, welche die Suche drastisch beschleunigen können.

Die Sterne-Bewertung stellt ein sehr auffälliges Element dar, ist aber bei weitem nicht alles, was Rich-Snippets zu bieten haben.

Es gibt eine Vielzahl von verschiedenen Arten, wie bereits in der Abbildung angedeutet.

Es muss bei der Auszeichnung der Daten lediglich darauf geachtet werden, dass der Code exakt den Richtlinien und Anforderungen entspricht, so dass die Suchmaschinen diese auch verstehen und auswerten können.

Um welche Richtlinien handelt es sich hierbei, wo findet man sie und wie werden diese definiert?

2011 wurde www.schema.org von Microsoft, Google und Yahoo! gegründet. Auf dieser Seite werden die einheitlichen Richtlinien für die Auszeichnungen von strukturierten Daten bekannt gegeben.

Yandex, die größte Suchmaschine Russlands hat sich dieser Initiative angeschlossen.

Webentwickler haben somit den Vorteil, sich nur nach einer Regelung richten zu müssen, sodass nicht für jede Suchmaschine ein spezielles Markup notwendig ist.

Durch schema.org wird also den Webmastern mitgeteilt in welcher Form strukturierte Daten übermittelt werden können. Durch diese Auszeichnungen können Suchmaschinen die Informationen besser erkennen, deuten und verarbeiten.

Ob es sich nun um Erfahrungsberichte, einzelne Personen oder Produkte, Unternehmen, Vereine oder Organisationen, Rezepte, Veranstaltungen oder Musik handelt, es wird bereits ein breites Spektrum angeboten.

Suchen wir bspw. nach einer Band, so wird in den Suchergebnissen nicht nur der Name dargestellt, sondern ebenfalls einige Lieder des Interpreten mit der jeweiligen Spieldauer.

Derartige Informationen sind von bedeutendem Interesse für den Suchenden. In jedem Fall erhöht es die Chance, dass der Suchende sich für dieses Ergebnis entscheidet, da es den reichsten Informationsgehalt verspricht.

Den Quellcode aufzubereiten, sodass Informationen strukturiert übermittelt werden können, ist kein Hexenwerk. Es gibt bereits Werkzeuge, mit denen sich der entsprechende Code automatisch generieren lässt (z.B. www.schema-creator.org).

Vorteile durch Rich-Snippets

Durch strukturierte Daten können die eigenen Seiten in den Suchmaschinenergebnissen anderen Seiten gegenüber deutlich hervorgehoben und besser dargestellt werden.

Dies kann sehr wertvoll für den Betreiber der Website sein, denn durch die zusätzlichen Informationen und die optische Hervorhebung, wird sich die Klickrate ebenfalls erhöhen und dadurch wird zudem den Suchmaschinen signalisiert, dass diese Seite für die jeweiligen Keywords relevant und beliebt ist.

Cross-Linking

Verlinkungen zwischen ähnlichen Artikeln, welche zueinander gehören oder in Beziehung stehen, können sehr mächtig sein. Diese helfen den Suchmaschinen dabei, mit einer größeren Sicherheit bestimmen zu können, wie relevant eine Seite zu einem bestimmten Thema ist.

Dies kann die Entwickler und Designer vor sehr schwere Herausforderungen stellen, vor allem dann, wenn es sich um einen großen Onlineshop mit einer Vielzahl an Artikeln handelt.

Bereiche wie „Häufig zusammen gekauft“ und „Was haben Kunden gekauft, nachdem sie diesen Artikel gesehen haben?“ sind eine gute Möglichkeit eine Gruppe von Produkten in Kategorien zusammenzufassen, welche die Relevanz der Seite zu bestimmten Themengebieten herstellen, sowie um Verlinkungen zwischen relevanten Seiten zu ermöglichen.

Sie sollten eine Website-Architektur planen, welche es ermöglicht, verwandte Elemente miteinander zu vernetzen.

Weitere Faktoren

Einige wichtige Faktoren wurden bereits genannt. In diesem Kapitel wird auf weitere Punkte eingegangen, welche von Bedeutung sein können.

Einsatz und Gewichtung hängt vom jeweiligen Anwendungsfall ab.

Performance

Laut Matt Cutts, einem leitenden Angestellten von Google, ist die Performance einer Seite ein Rankingfaktor. Klingt logisch oder?

Eine zu lange Ladezeit kann das Erfassen der Seite durch die Suchmaschinen und die Indexierung verlangsamen.

Nicht nur Google freut sich über schnelle Ladezeiten, sondern vor allem der Besucher, welcher eventuell nicht über die beste Internetverbindung verfügt.

Zu lange Ladezeiten führen mit großer Wahrscheinlichkeit dazu, dass der Besucher die Seite verlässt, bevor diese überhaupt erst geladen wurde.

Unter folgendem Link kann die URL der zu analysierenden Seite eingegeben werden und das Tool von Google „PageSpeed Insights“ liefert nach kurzer Wartezeit wertvolle Ergebnisse mit Hinweisen zur Optimierung:

Analyse mit PageSpeed Insights

Generell bieten sich mehrere Techniken immer an um die Performance einer Seite zu optimieren.

Das komprimieren von JavaScript- und CSS-Dateien, Bildern und HTML-Code sind hierbei die geläufigsten Methoden.

Die richtige Konfiguration der Module auf dem Server hat ebenfalls Einfluss auf die Ladezeit, hier sollte bspw. KeepAlive aktiviert werden.

Bei KeepAlive handelt es sich um einen Mechanismus, welcher das Ziel verfolgt eine Verbindung aufrecht zu erhalten.

PDF-Dokumente

Befinden sich PDF-Dokumente auf Ihrer Plattform, so gilt es diese ebenso zu optimieren wie Ihre HTML-Dateien. Generell gelten dieselben Regeln wie für die Publikation von HTML-Dokumenten, wenn man von den speziellen HTML-Eigenschaften absieht.

Bei der Konvertierung von PDF-Dateien werden Felder zur Verfügung gestellt, welche die Platzierung von Meta-Informationen ermöglichen. Besonders ratsam ist es hier das Title-Feld mit denselben Schlüsselbegriffen wie die des Title-Elements der jeweiligen Seite zu bestücken. Eine thematische Strukturierung von Überschriften und Abschnitten ist hier ebenfalls ein wichtiger Faktor.

Robots.txt

Mit Hilfe einer robots.txt Datei kann angegeben werden, welche Seiten der Plattform durch die Crawler der Suchmaschinen besucht werden dürfen und welche nicht.

Sollte es z.B. noch Seiten geben welche sich im Aufbau befinden, so können diese von der Indexierung ausgeschlossen werden.

Es kann ein Hinweis auf die Sitemap der Website gesetzt werden, was die Übermittlung und das Einlesen der Seite für die Suchmaschinen erleichtert.

Die robots.txt befindet sich in der Regel im Hauptverzeichnis.

Verwenden Sie die Google Search Console um Ihre robots.txt Datei zu überprüfen.

Domain-Alter

Das Alter einer Domain ist als Rankingfaktor zu berücksichtigen.

Mit steigendem Alter erhöht sich deren sogenannter Trust, welcher für das zugemessene Vertrauen von Google steht.

Bei Seiten welche über einen längeren Zeitraum unter einer bestimmten Domain online sind, hat Google die Möglichkeit bereits auf etliche Daten zuzugreifen und diese auszuwerten.

Das erleichtert es der Suchmaschine eine genaue Aussage zu treffen, ob es sich bei der Seite um eine relevante oder eine weniger wichtige Website handelt.

Beschreibende URLs

Eine gute URL besitzt einen einprägsamen und kurz gehaltenen Namen.

Der Idealfall lässt den Besucher anhand der URL auf das Thema der jeweiligen Seite schließen.

Stellen Sie sicher, dass Sie saubere, kurze und beschreibende (sprechende) URLs besitzen. Beschreibend bedeutet reich an Schlüsselwörtern, aber nicht vollgestopft.

Sie wollen keine angehängten Parameter, welche in der URL erscheinen (wenn dies unumgänglich ist, ist eine kleine Anzahl vertretbar). Sie wollen einfache, leicht verständliche URLs für den Anwender sowie Crawler anbieten.

Dadurch wird es dem Besucher ebenfalls erleichtert sich eine bestimmte Adresse zu merken. In den Suchergebnissen werden die URLs von Unterseiten neben der Domain auch angezeigt. Deren Darstellung kann also durchaus einen Faktor für die Klickrate darstellen.

Problemquellen

Es gibt eine Vielzahl von Problemen welche auftauchen können, ohne dass der Webmaster oder Shop-Betreiber hiervon etwas merkt.

Die wichtigsten werden nachfolgend benannt und sollten je nach Möglichkeit vermieden werden.

Sackgassen

Man bezeichnet derartige Seiten als Dangling Pages, diese stellen einen blinden Endpunkt innerhalb einer Verlinkungskette dar.

Aus diesen Endpunkten kann sich der Besucher nur über die Zurück-Funktion herausnavigieren.

Derartige Einbahnstraßen gilt es strikt zu vermeiden, daher sollte es von jeder Seite zumindest eine Navigationsmöglichkeit zur Startseite geben, von der aus sich der Benutzer dann neu orientieren kann.

Unnötige Subdomains

Die Suchmaschinen können eventuell die Gesamtheit der Vertrauenswürdigkeit einer Domain nicht erfassen.

Dies ist vor allem der Tatsache geschuldet das eine Subdomain unter der Kontrolle einer anderen dritten Partei sein könnte. Deshalb müssen, aus der Perspektive der Suchmaschinen, diese separat evaluiert werden.

In einer großen Mehrheit der Fälle kann der Inhalt von Subdomains einfach in einen Unterordner abgelegt werden.

JavaScript, Java oder Flash

Suchmaschinen fällt es schwer Inhalte oder Verlinkungen zu sehen und zu verarbeiten, wenn diese in Skripten etc. vorliegen.

Stellen sie sicher, dass Ihre Links und Inhalte über einfachen HTML-Text strukturiert und dargestellt werden.

Inhalt hinter Formularen (inkl. Pull-down Listen)

Inhalt welcher erst nach dem Ausfüllen eines Formulars oder ggf. eines Logins zugänglich gemacht wird, kann von Suchmaschinen nicht erkannt werden.

Also nutzen Sie diese Techniken nicht, es sei denn Sie möchten Inhalte ausblenden.

Eingangsseiten

Bei Eingangsseiten handelt es sich um inhaltsleere Seiten, welche den Besucher auf die eigentliche Seite führen. Manchmal wird hier mit Multimedia-Spielereien gearbeitet, oft sind es aber nur einfache statische Willkommensseiten, welche den Besucher über einen Link auf die Inhaltsseiten lotsen.

Da Google nicht gerne auf inhaltsleere Eingangsseiten in seinen Suchergebnissen verweist, sollten diese möglichst vermieden oder wenn bereits vorhanden, abgeschafft werden.

Zudem sind derartige Seiten fast immer ein Indiz für schlechtes Webdesign.

Stellen Sie sicher, dass bereits auf der Startseite generell wertvolle Informationen in Form von informativen Texten angeboten werden.

Session IDs oder User IDs in der URL

Früher war es häufig der Fall für CMS einzelne unterschiedliche Benutzer mit Hilfe eines Tracking-Codes am Ende der URL zu verfolgen.

Obwohl dies für diesen Zweck gut funktionierte war es für Suchmaschinen hingegen weniger vorteilhaft.

Jede URL wird als eine unterschiedliche Seite gesehen, anstatt dass es sich hier um unterschiedliche Varianten derselben Seite handelt.

Stellen Sie sicher, dass Ihr CMS oder Shopsystem niemals Session-IDs auftischt.

Überflüssige Flags in der URL

Diese machen Google vielleicht nichts aus, können aber andere Suchmaschinen stören und wirken sich auch nachteilig auf die User-Experience einer Plattform aus.

Wenn sich in der URL lauter kryptische Zeichen befinden, mit denen der Anwender nichts anfangen kann, so sollten diese ihm auch nicht dargestellt werden.

Duplicate Content

Wenn die Struktur der URLs verändert wird, muss darauf geachtet werden das Google unter den alten URLs keine Inhalte mehr erreichen kann.

Der erste Gedanke das mit mehr Verlinkungen, mehr Volumen und somit mehr Möglichkeiten für potenzielle Besucher entstehen um auf die Website zu gelangen, ist naheliegend. Allerdings wertet Google dies als Täuschungsversuch, da gleicher Inhalt mehrmals zur Verfügung steht.

Derartige Inhalte werden als Duplicate Content bezeichnet.

Expertentipp

Überprüfen Sie ob die nicht-www-Version Ihrer Seiten (z.B. http://ihreseite.de) mit einem 301-redirect auf die www-Version Ihrer Seite (z.B. http://www.ihreseite.de) verweist oder umgekehrt.

Während Sie schon dabei sind überprüfen Sie gleich ob Ihre https: Seiten (sofern vorhanden) keine Duplikate Ihrer http: Seiten sind.

Der einfachste Weg dies zu tun besteht darin, einzigartige Strings (Textstücke) aus jeder Hauptinhaltsseite Ihrer Website zu kopieren und danach in Google zu suchen.

Stellen Sie sicher, dass Sie den Textausschnitt in Anführungszeichen setzen (z.B.: “ein Textausschnitt Ihrer Seite“) damit wird sichergestellt, dass Google nach exakt demselben String sucht.

Sollte Ihre Seite einen zu monströsen Umfang besitzen und somit einen zu großen Arbeitsaufwand darstellen, stellen Sie sicher, dass Sie die wichtigsten Seiten überprüfen und einen Prozess besitzen, mit dem Sie neue Inhalte einer Überprüfung unterziehen, bevor Sie auf Ihrer Seite live gehen.

Expertentipp

Es besteht unter anderem auch die Möglichkeit Befehle wie inurl: und intitle: zu verwenden um Ihre Seite auf doppelte Inhalte zu untersuchen.

Wenn Sie zum Beispiel URLs besitzen, welche unverwechselbare Komponenten beinhalten, können Sie nach diesen mit Hilfe des inurl: Befehls suchen und feststellen, ob Sie auf mehr als einer Seite zurückgegeben werden.

Eine weitere Duplicate Content Aufgabe, welche erfüllt werden sollte, ist das Sicherstellen, dass jedes Stück von Inhalten lediglich unter einer URL zu erreichen ist. Dies stellt für große kommerzielle Seiten wohl am ehesten ein Problem dar.

Das Problem ist, dass derselbe Content über mehrere Wege erreichbar ist, was die Suchmaschinen (und Besucher) dazu zwingt sich zu entscheiden, welche nun die zu verknüpfende kanonische URL ist und welche nicht.

Keiner gewinnt, wenn Seiten sich selbst bekämpfen.

Wenn Sie Inhalte über verschiedene Wege darstellen müssen dann benutzen Sie Cookies, so dass die Crawler nicht irritiert werden.

Inhalte auf dynamisch generierten Seiten

Wichtige Inhalte sollten in keinem Fall auf dynamisch generierten Seiten platziert werden.

Expertentipp

Da dynamische Inhalte auf das Interaktionsverhalten des Besuchers hin unterschiedlich angezeigt werden, kann dies bei einem Indexroboter zu Problemen führen, da dieser kein menschliches denkendes Wesen ist.

Je nach Seite kann es dazu kommen das der Crawler Unmengen an Seiten erzeugt, bis hin zum Absturz der Seite oder des Servers.

Im Regelfall verlässt ein Crawler deshalb die Seite sofort, sobald er dynamisch erzeugte Inhalte trifft.

Frames

Suchmaschinen fällt das Indexieren von Frame-Seiten sehr schwer. Hier wurden bereits große Fortschritte erzielt, allerdings kommt es in den häufigsten Fällen immer noch zu Fehlern.

Wieso bereiten Frames den Suchmaschinen derart große Probleme?

Expertentipp

Sollte der Einsatz von Frames unabdingbar oder gewollt sein, so muss darauf geachtet werden, dass die Website Google- und Benutzerfreundlich ist.

Dies geschieht indem Links zu den Seiten mit denselben Inhalten, nur ohne Frames, zur Verfügung gestellt werden.

Der Google-Spider hat so die Wahl und kann die Informationen problemlos erfassen. Dem Besucher wird ebenfalls zusätzlich die Möglichkeit geboten den Anzeigemodi selbst auszuwählen.

Tricks gegenüber Google

Auch Suchmaschinen werden von Spam nicht verschont, dabei steht Spam hier für alle möglichen Methoden, welche Suchmaschinen täuschen und mit falschen Informationen füttern.

Es gibt eine Vielzahl an Tricks mit denen sich Suchmaschinen manipulieren lassen um bessere Platzierungen auf den Ergebnisseiten zu erzielen.

Kein Bedarf

Da es aber keiner seriösen Arbeitsweise entspricht, die Suchmaschinen immer raffinierter werden und Google beim geringsten Anzeichen von Manipulation sehr streng verfährt, soll dieser Punkt hier nicht weiter erläutert werden.

Ihr Ansprechpartner für eine professionelle OnPage-Optimierung

Sind Sie auf der Suche nach einer Werbeagentur, welche die OnPage-Optimierung für Sie übernimmt und Ihnen mit Rat und Tat zur Seite steht?

Dann sind Sie bei smarterPresence an der richtigen Adresse.